Au départ, j’ai failli intituler mon article « Humilité épistémique : comment éviter l’effet Dunning-Kruger ?« , mais ce jargon zet n’était pas assez sexy… et on va le voir, l’effet DK est, en plus, désormais remis en questions.

Pour ceux qui connaissent pas ces mots, ce dont on va parler ici, c’est la manière dont la surconfiance de plusieurs interlocuteurs dans leur appréciation d’un sujet (leur posture de certitude, en gros) les empêche de vraiment en comprendre les enjeux ou d’apprendre de leurs interlocuteurs plus compétents.

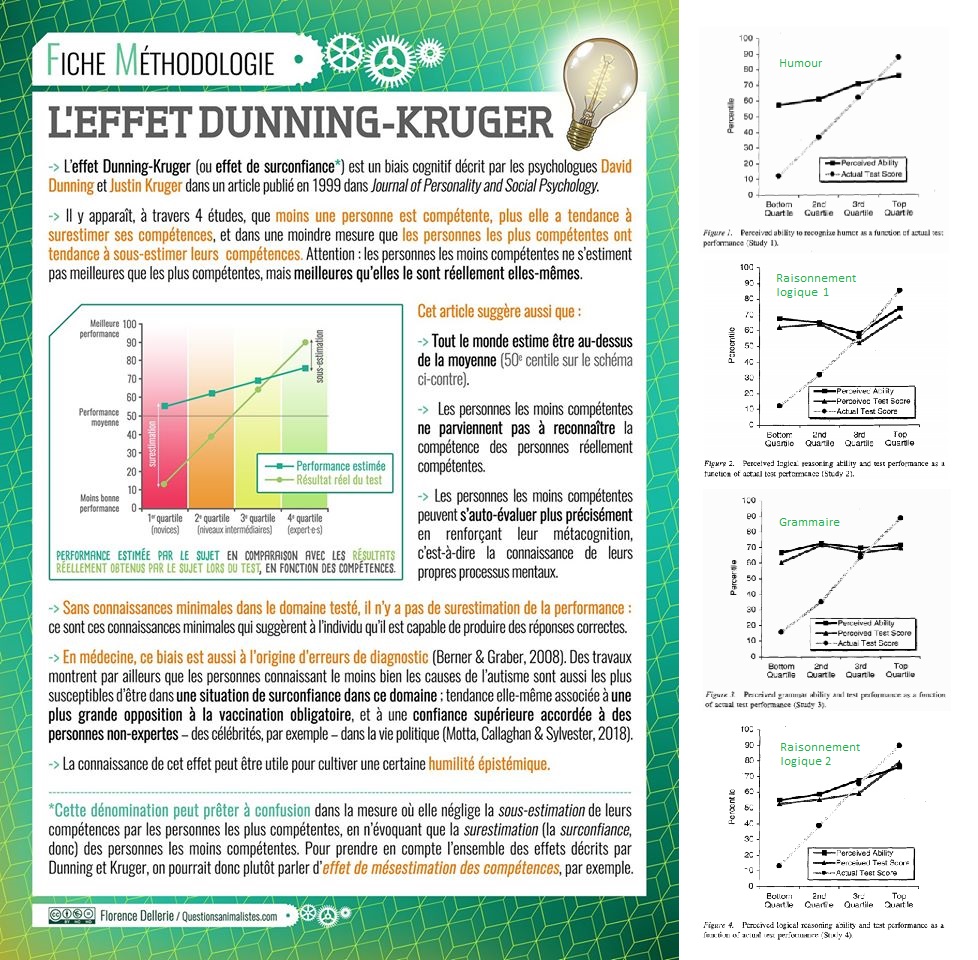

L’effet Dunning-Kruger, précisément, correspond au fait que le sentiment de compétence augmenterait moins vite que la compétence réelle (mais contrairement à une idée reçue, ne serait pas « inversement corrélée » à, il augmente quand même avec la compétence réelle). Cet effet est expliqué en détail dans cette infographie de Florence Dellerie :

Bon, comme je le disais, il faut cependant savoir que l’effet Duning Krugger est en ce moment remis en question : il ne s’agit probablement que d’un artefact scientifique. Il n’y a pas forcément de lien statistique entre les compétences réelles, et la SURconfiance qu’on a dans ses compétences. Et donc, on aurait tendance à avoir moins confiance en soi *en moyenne* quand on est moins compétent. En moyenne. Mais ça n’empêche pas que localement, certains individus auront une confiance dans leur compétence qui n’est pas en accord avec leur compétence réelle. Je propose qu’on garde dans la suite de cet article le terme de surconfiance pour qualifier cela.

Cette infographie m’a rappelé à une réflexion qui me taraude depuis pas mal de temps, sur la surconfiance, et qui reste une question valide même si Dunning-Krugger est un artefact : comment faire, pour dire aux gens « si vous êtes compétent, prenez confiance en vous car vous vous sous-estimez peut-être, mais si vous n’êtes pas compétent, revoyez votre confiance à la baisse car vous vous surestimez peut-être» sans que ceux qui surestiment leur compétence n’en profitent pour se dire « ah mais voilà, moi je suis compétent, alors mes quelques doutes qui me restent là, je les étouffe, il faut que je prenne confiance » ? Dans les travaux sur la surconfiance, la compétence est estimée par un « score » issu d’un test qui la mesure. Mais dans la vraie vie, on estime comment ?

Les diplômes ? Le cas Raoult (dois-je détailler pour ceux qui liront cet article dans 10 ans ? Cf. Note1) et en fait plus généralement le syndrome du Nobel montrent largement que les conséquences d’un effet Dunning-Kruger sont d’autant plus graves que la personne peut se servir de ce CV pour imposer son autorité, et ça me semble donc peu judicieux de se baser sur ce critère. En fait, typiquement, si on prend le cas Raoult : de nombreux autodidactes non-biologistes ont très bien vu les lacunes de son travail. Et ce n’est pas la première fois que j’observe ce phénomène : dès lors qu’on s’éloigne un tout petit peu de la spécialité exacte d’un spécialiste, plein d’autodidactes sont aussi compétents que les gens ayant des diplômes, même dans la discipline adéquate, sur la plupart des sujets 2. En d’autres termes : si vous êtes spécialiste de peinture vénitienne du XIIIe siècle, vos diplômes ne vous donnent probablement pas d’avantage de compétence sur l’art contemporain que celles qu’à n’importe quel autodidacte passionné par ce sujet. A moins d’être vous aussi un autodidacte, par passion, sur ce domaine. Moi-même, j’ai des compétences pointues en biologie de l’évolution, mais je n’ai pas d’avantage (voir moins) de compétences qu’un autodidacte passionné ou qu’un étudiant de L3 en ce qui concerne la physiologie végétale. Avoir des diplômes en statistiques appliquées à la psychologie et travailler sur la question de la perception du hasard ne donne pas de compétence spécifique sur les questions de genre et encore moins sur les questions de génétique quantitative (hérédité, inné / acquis, etc.)3.

Bon. Donc, comment gérer cet effet Dunning-Kruger? On a cette fâcheuse tendance dans les milieux rationalistes à dire « attention à pas faire ça » (ne tombez pas dans tel biais, ne tombez pas dans l’effet Dunning Kruger, ne faites pas ci, etc.). On l’a déjà défendu dans « Les gens pensent mal, le mal du siècle ? » et la série «Biais idéologique» le problème, quand on dit quoi ne pas faire, mais sans dire quoi faire, on a plein de gens qui vont tomber dans la pétition de principe « oui moi je lutte contre mes biais ». On voit plein de gens qui affirment « faire attention », mais le secret de comment ils font reste toujours bien gardé. Or il me semble qu’on pourrait utiliser un des principes d’éducation positive, ici, en fait: « ne dites pas aux enfants d’arrêter de courir, dites-leur de marcher ». On va tenter un truc comme ça. Je vais livrer comment je procède pour chercher à éviter ces travers (qui est un mix entre des principes et outils issus de ma formation et ma pratique académique, et des astuces persos), et je serais heureuse que d’autres me donnent leurs méthodes. C’est ainsi qu’on devrait progresser.

Bon. Il y a deux problèmes que pose l’effet Dunning Kruger : comment savoir à quelle parole faire confiance, e.g. qui est compétent sur quoi, et comment savoir si soi-même, on n’outrepasse pas ses propres compétences.

Reconnaitre qui est compétent.

Pour ce qui est de reconnaitre la compétence d’un discours, je pense que chacun fait un peu à sa sauce, et que ce serait bien que ce soit plus discuté. Là je donne ma sauce perso, récupère qui voudra. Quand je lis un texte, la première chose que je fais, c’est vérifier s’il y a concordance entre ce qui y est dit, et ce que je sais déjà du sujet. Plus j’ai une bonne culture générale dans le sujet, plus j’ai de chance de détecter des discordances, et donc le fait que la source maitrise ou non ledit sujet. Je tente de forger ma culture générale pour cette raison : il me semble que c’est la première arme à avoir pour pouvoir avoir un recul critique sur les sources; détecter les bugs. Évidemment, j’ai des lacunes.

Alors comment faire quand on a des lacunes ? Il y a deux stratégies possibles. Premier cas de figure : s’il n’y a pas le feu au lac, on n’a pas besoin de conclure, ni de s’exprimer. Je n’avais aucune idée de quoi penser de la loi sur le voile en 2004. Pendant 10 ans, je n’ai jamais donné mon avis sur le sujet. Mais j’ai lu tout ce que je pouvais. Je ne me le suis forgé qu’en 2014, 10 ans plus tard, et suite à ça, je l’ai partagé un peu. Donc : je vois beaucoup de gens qui disent « ouais mais on a quand même le droit de s’exprimer, même quand on ne sait pas tout ». On ne sait jamais tout. Mais on ne sait pas rien non plus. Donc on peut bien s’exprimer sur des sujets. Mais quand on « ne sait pas » sur un sujet, si, vraiment : on se tait. Ça me semble être le minimum. Deuxième cas de figure : s’il y a le feu au lac, ou si on veut se la forger, cette culture générale qu’on n’a pas, comment faire pour trancher et trier les sources, malgré ses lacunes ? Personnellement, j’ai un réseau de gens, avec des spécialités diverses. Des gens que je sais compétents sur tel ou tel domaine. Et quand je ne suis pas sure, je leur envoie la source et je leur demande « tu penses quoi de cette source ? ». Et d’autres gens font pareil avec moi. Un truc en bio, on me demande ce que j’en pense. Si vous n’avez pas de formation scientifique, ne sous-estimez pas ce que vous pouvez apportez à un tel réseau : vous êtes au minimum expert de vos vies, et vos paroles de concernées par telle ou telle chose à une valeur informative. Si la source parle de faits sociaux et que votre vécu ne concorde pas avec ce qui est décrit, c’est informatif. Au final, on va devoir passer par une dépendance épistémique… mais c’est quand même mieux de le faire avec des gens dont on a les moyens d’estimer la rigueur, parce qu’on les connait dans la durée (attention, ça demande aussi une sorte de pré-travail, finalement, on peut être d’accord avec une personne sur plein de sujets, sans que cette personne soit très rigoureuse… un bon indice est je crois la capacité à faire des correctifs publics quand on signale une erreur : comme c’est couteux pour l’égo, ça indique une propension à faire passer la rigueur avant le reste).

La deuxième chose que je regarde, c’est l’orientation politique de la source. On peut regarder sur un wiki, ou demander à des contacts familiers avec la source. Ça permet de savoir ce qui a des chances d’être défendu, et le cadrage qui a des chances d’être effectué. Attention, le positionnement politique se détermine par une analyse du discours, pas par le positionnement que ladite source prétend avoir (sachant que les sources d’extrême droite se prétendent souvent plus modérées qu’elles ne le sont, et que les sources « centristes » se pensent apolitiques).

Mettons cela en application avec cet article de l’AFIS, il n’y a a priori pas de hoax dedans (pas trop de discordance avec ce que je sais du sujet, à part que l’approche One Health, c’est pas du tout ça… attention, l’AFIS a été épinglé par ailleurs pour ses hoax, ils n’en sont pas exempts4), alors avec la 1ere méthode, cet article spécifique passe le filtre. En revanche, si je regarde le cadrage, ce qui est dit versus ce qui n’est pas dit, je remarque que par exemple, si on voulait faire le tour de la question des faits sur les OGMs, là ça parle de santé humaine, mais ça zappe totalement les aspects écologie-évolution, notamment sur la question de la diversité génétique des semences (voir par exemple les conférences de Pierre-Henri Gouyon). Alors on peut être en désaccord avec les arguments, et y répondre. Là, le choix est fait de ne pas en parler. Pour voir ce qui « manque », il faut une culture générale solide, mais ce n’est pas quelque chose qu’on est forcé d’avoir soi-même : c’est une tâche qui peut être assurée par le réseau qu’on s’est constitué (j’insiste, il s’agit d’un réseau dans lequel on connait la rigueur et le domaine de compétence de chacun, il ne s’agit pas de demander à des zététiciens inconnus en supposant qu’ils sont compétents juste parce qu’ils l’affirment). Si je fais ça un peu pour tous les sujets traités par ce média, je me rends compte qu’il y a un cadrage qui globalement défend les technologies, un cadrage pro-industrie. Je peux utiliser ce média comme source pour être à jour sur leurs arguments, mais je devrais toujours confronter à ce que disent d’autres sources pour avoir une vision plus globale du problème (et vérifier qu’ils ne déforment pas les faits). Et je vais éviter de partager les articles de ce média (ou si je le fais, exceptionnellement, ce sera avec un warning), pour éviter que d’autres contacts moins vigilants se fassent avoir par ce biais de cadrage ou leurs hoax (quitte à faire une synthèse, pour mes contacts, et à fournir un discours qui évite les hoax ET ledit biais de cadrage).

Donc, une fois les sources triées, je lis, je compile, je confronte, et je continue d’apprendre. Quand pour un sujet, au bout d’un long moment, je ne tombe plus sur aucune nouvelle idée, je considère que j’ai probablement assez fait le tour pour me forger un avis.

Délimiter ses propres compétences.

La délimitation que je vais faire, intuitivement, de mes propres compétences, découle assez naturellement de la démarche ci-dessus. Je me sens compétente quand 1- j’ai passé du temps sur un sujet, et 2- je ne rencontre quasiment plus aucun discours dont je n’ai pas déjà (vraiment) intégré les arguments à ma compréhension du sujet. Et j’ai expliqué comment faire ça dans Humilité épistémique, la clef pour convaincre éthiquement, et sa suite, sur l’application à des sujets de société (articles qui à la base étaient écrits pour être collés ici, mais ça faisait bien trop long, alors j’ai scindé). Il s’agit, pour résumer, de prendre les arguments d’autrui au sérieux, et de voir en quoi ils s’intègrent à une description de la réalité plus complète que celle qu’on avait en tête jusqu’alors. Par exemple, dans le premier article, j’explique comment réconcilier la vision d’une personne qui pense que le paludisme est causé par le soleil avec la conception scientifique selon laquelle il est causé par le parasite Plasmodium transmis par des moustiques anophèles. Comme expliqué, il ne s’agit pas d’adhérer à la première intuition qu’on a de ce que « signifie » la croyance de l’autre, ce qui réduit notre panel d’interprétation de ce qu’il peut vouloir dire, mais il s’agit de comprendre comment elle (cette croyance) pourrait faire sens en changeant de perspective (je ne spoile pas les deux articles, vous pourrez les lire après celui-ci).

Alors attention, une fois la réconciliation effectuée et le ‘seuil de saturation’ (aucune idée nouvelle rencontrée) atteint, est-ce que pour autant je dois me fier à ce sentiment de compétence? Ou bien ces deux critères sont-ils nécessaires mais non suffisants? Récemment, on a vu dans la sphère sceptique twitterienne (ici, ici, et là) le Dr Baratin (docteur en didactique des sciences, travaillant sur l’argumentation et l’esprit critique) appeler la communauté zététique à être plus attentive aux contenus de la littérature scientifique sur l’esprit critique (la manière dont il est défini, ses liens avec « la méthode scientifique », l’argumentation, son lien avec les valeurs qu’on porte, etc.). En effet, beaucoup de personnes qui se positionnent sur le sujet dans des vidéos de vulgarisation ne semblent pas toujours au fait des bases de cette littérature (les mauvaises conceptions ont été très bien expliquée dans ce live « Les sceptiques sont-ils spécialistes de l’esprit critique » – dont nous conseillons plus que vivement le visionnage – qu’il a dispensé en duo avec Langue de Cha’, qui elle même effectue son doctorat sur les différentes conceptions de l’esprit critique). Moi même, j’ignorais, jusqu’aux threads twitter de Dr Baratin, qu’il existait un tel champ de recherche, et je n’aurais pas eu l’idée d’aller fouiller cette littérature par moi même avant de tenter de donner une définition de l’esprit critique, si on me l’avait demandé. C’est entre autre lié à la multitude de contenus qui circulent sur le sujet, qui donne une illusion de familiarité (j’ai visionné un grand nombre de contenus sceptiques, je fréquente les sphères sceptiques depuis de nombreuses années, j’ai suivi des MOOC sur le sujet, notamment un récent de l’UBL mais qui lui même tombait dans certains écueils courants, etc.). Et avec du recul, la familiarité ne suffit pas… il y a toujours un risque, à l’intérieur d’une communauté (même scientifique, par exemple au sein d’une discipline spécifique!), de croire savoir de quoi on parle car on n’est exposé qu’aux conceptions internes à la communauté, mais pas aux conceptions qui lui sont externes. Le problème est multiplié lorsqu’on affiche un contenu étiqueté « scientifique » ou « sceptique », puisque les auditeurices considéreront d’autant plus par défaut qu’on a été rigoureux et qu’on a vérifié ses sources (alors que vraiment, c’est loin d’être une garantie, voir Quand les scientifiques diffusent des mythes, par la chaîne Malin Génie). Il y a donc une lourde responsabilité, pour les vulgarisateurs, de sciences ou d’esprit critique, à remonter à la source, à fouiller la littérature un minimum par des mots clefs, et à ne pas se limiter à quelques autres supports de vulgarisation qu’on aurait vus, que ce soit des livres, Wikipédia, ou d’autres vidéos, si on veut vulgariser soi-même. Il est clair que c’est couteux en termes de vitesse de production. Un des gros défauts qu’on a sur le présent site, c’est notre lenteur. C’est aussi mon plus gros défaut pour faire des publications académiques: je crains toujours d’avoir loupé des trucs, et c’est ce qui me pousse à avoir des brouillons qui s’écrivent pendant des années et des années (pas parce que j’y bosse à plein temps hein, mais parce que le soucis de ne pas avoir fait une biblio suffisante me conduit à procrastiner, aussi). Il y a un trade-off négatif, entre prendre le temps de s’assurer qu’on n’a rien loupé… et finir par produire. Idéalement, il faudrait que la subsistance des personnes qui produisent des contenus ne dépende pas de leur vitesse de production, car il est indéniable que cela conduit à une pression qui ne peut qu’abaisser la qualité5 (pensée pour Darwin et son soucis d’exhaustivité, et non, je ne prône pas ici le salaire universel… mais bien le communisme 😉 ). Cela vaut aussi pour la recherche scientifique (mais ça ne va pas s’arranger, si on regarde ce qui nous attend avec le plan pluriannuel de programmation de la recherche, ou LPPR).

Au final, comment faire correctement ce compromis, entre l’impossibilité d’être exhaustif dans la lecture de sources, et la nécessité de produire ou communiquer? J’aurais tendance à dire que déjà, ça dépend des supports via lesquels on s’exprime. Dans un débat entre amis ou dans un échange informel, il parait suffisant de s’appuyer sur son état des connaissances ponctuel, tout en restant vigilant aux moins aux deux premiers critères (i, avoir passé du temps sur un sujet, et ii, effet de saturation = on ne rencontre plus de nouvelles idées, ou au moins, on a déjà intégré les arguments adverses à sa représentation globale du sujet). Lorsque l’on vulgarise via des billets de blog ou des vidéos Youtube amateur, il convient de faire un minimum de recherches bibliographiques (critère iii), quitte à délimiter dans le contenu le domaine de validité de ses affirmations, ou repréciser que l’on n’aborde pas tout, par des phrases explicites qui indiquent ce qui est couvert; et ce qui ne l’est pas. Par exemple « du point de vue de la parasitologie, le paludisme est une maladie provoquée par un parasite du genre Plasmodium et transmis par des moustiques Anophèles. Dans les conceptions sociales, le paludisme peut avoir d’autres définitions, mais nous laissons cette problématique aux SHS » ou « L’un des arguments contre la 5G est l’émission d’ondes qui seraient nocives pour la santé humaine. Nous aborderons cet argument, sans pour autant trancher sur le bien fondé global de la 5G, étant donné qu’une partie des arguments ne seront pas abordés ici » (plutôt que « les gens refusent la 5G parce qu’ils croient à tort que leurs ondes ont un effet nocif sur la santé humaine »). Ici, j’ai un petit bagage sur ce qu’est l’effet Dunning-Kruger, j’ai lu la publication d’origine notamment, mais je n’ai pas fait la biblio pour savoir « comment lutter contre l’effet Dunning Krugger » : comme je le dis dès le départ, j’évoque ma propre manière de l’éviter, et ça n’a de validité que pour ouvrir une discussion, au final. Si je le précise, mes lecteurs savent le domaine de validité des mes propos, et peuvent décider d’aller compléter leurs connaissances en faisant une recherche eux-même dans la littérature sur le sujet. Ainsi, je peux témoigner de mon appréciation d’un sujet, tant que d’emblée, je précise bien qu’il ne s’agit que de ça, tant que je délimite clairement ce qui relève d’un travail bibliographique, versus ce qui relève de mes réflexions personnelles. Ça me permet de publier ce billet de blog (sans quoi il devrait probablement attendre encore un an, en fait), et d’atteindre mon objectif, qui est effectivement d’ouvrir la réflexion. Enfin, si je réalise des contenus pour une très grosse production (télévision, musée, etc.), et notamment que j’ai un label institutionnel ou un salaire pour réaliser le contenu (et que cela impacte la confiance que mon auditoire accorde à mes propos et mes conclusions), là, il me semble que le seuil d’exigence doit être vraiment plus élevé, et qu’il faut vraiment éviter de laisser des angles morts du sujet sous silence (ne serait-ce qu’en précisant les enjeux de s’intéresser aussi à ce qu’on n’a pas traité)…. au final, tout comme dans la section « perspectives » d’une publication scientifique.

En résumé. Je lutte principalement contre le risque de tomber moi-même dans l’effet Dunning-Kruger en ne prenant pas les gens pour des idiots, et en tentant de prendre au sérieux leur description du monde, pour comprendre réellement pourquoi elle diffère de la mienne, et enrichir mes connaissances et ma compréhension du monde. Je ne me sens pas confiante dans mes compétences tant que j’ai le sentiment de ne pas avoir compris les arguments du camp adverse, s’il y en a un. Mais, en particulier sur les sujets non polémiques, qui du coup ne suscitent pas d’arguments contradictoires, je pense avoir encore des progrès à faire pour me méfier de mon impression de familiarité. On va tâcher….

Et vous ?

Merci à Rony, Gaël Violet, Phil, Dr Baratin, Émeric, et Pavel pour leurs retours. Merci aussi à Florence Dellerie pour sa relecture et l’autorisation d’utiliser son infographie.

Notes :

- Nous sommes au milieu de la 1ere pandémie. Oui je mets la première, qui sait ce que l’avenir nous réserve hein. Raoult est un médecin-chercheur plutôt virologue qui a fichu le boxon dans la sphère publique et généré mille théories du complot en prétendant qu’un remède miracle allait tous nous sauver et autres âneries.

- Et il paraitrait que Kuhn en parle dans La structure des révolutions scientifiques, mais ça fait des mois que cet article est en plan parce que je dois chercher la ref, alors je délègue à qui voudra chercher pour, m’aider en remerciant ce quelqu’un par avance. Tfaçon, ça me semble pas être un affirmation extraordinaire, j’espère qu’on m’accordera ce point même sans ref.

- Toute ressemblance avec des sceptiques existant ou ayant existé n’est pas fortuite.

- J’ai commis l’erreur de débutante de demander à Gaël Violet, dont la concision n’a jamais été le fort, de s’occuper de me rédiger une courte note pour illustrer les tendances de l’Afis à diffuser les fausses rumeurs qui l’arrangent. Résultat, la note a grossi, et grossi, jusqu’à prendre la taille d’un petit article, qui sera publié un jour séparément et dont nous insérerons le lien ici. Note : c’est lui qui a écrit cette note, moi je bashe pas comme ça.

- J’ai regardé la vidéo de Malin Génie après avoir écrit ces lignes, en finissant l’article… et bien ils concluent leur vidéo sur la diffusion des mythes exactement sur ça eux aussi, d’ailleurs… preuve d’à quel point c’est une question critique.

Petit ajout concernant Dunning Kruger, l’effet DK est potentiellement mis à mal dans la littérature mais il ne faut pas confondre DK (qui se focalise uniquement sur les compétences) et les autres effets de surconfiance comme par exemple l’illusion de profondeur explicative (surestimer combien on pense comprendre comment quelque chose fonctionne: https://www.ncbi.nlm.nih.gov/pmc/articles/PMC3062901 ), la surconfiance a détecter le « bullshit pseudoprofond » (http://journal.sjdm.org/15/15923a/jdm15923a.html), et d’autres effets d’illusion de connaissance pour des raisons très diverses (appliqué a la lutte anti-terroriste ici par exemple https://www.tandfonline.com/doi/abs/10.1080/17539153.2014.981400)

Il y a une variabilité importante de manières d’être en surconfiance

Un grand merci pour ces compléments !

Je garde en tête « LA MÉTAPHORE DES AVEUGLES ET DE L’ÉLÉPHANT » (je la connaissais depuis longtemps mais je viens d’apprendre son nom) https://fr.wikipedia.org/wiki/Anekantavada

qui est pour moi un très bon moyen de conserver son humilité épistémique. La comprehension de concepts de la philosophie Asiatique (paradigmes differents des notres mais non pas moins valides et enrichissants) m’a beaucoup aidé à assumer mon sceptiscisme et accepter un certain relativisme (personne ne peut connaitre/appréhender l’éléphant complétement).

Bonjour

En tant que membre de l’Afis (qui lira avec attention l’article de Gaël Violet à ce sujet), je me permets quelques remarques sur la partie à ce sujet.

« je remarque que par exemple, si on voulait faire le tour de la question des faits sur les OGMs, là ça parle de santé humaine, mais ça zappe totalement les aspects écologie-évolution, notamment sur la question de la diversité génétique des semences (voir par exemple les conférences de Pierre-Henri Gouyon). Alors on peut être en désaccord avec les arguments, et y répondre. Là, le choix est fait de ne pas en parler. »

Certes, et je pourrais aussi vous reprocher d’avoir fait le choix de ne pas parler de la famine au Yémen dans votre article. Et vous me répondrez que ce n’est pas le sujet. Sachant que le but de l’article que vous avez partagé n’est pas de parler des aspects écologie-évolution et diversité génétique, je ne comprends pas bien votre critique. Il existe beaucoup d’articles sur le site de l’AFIS qui parlent des enjeux écologiques liés aux OGM et à l’agriculture, je vous renvoie par exemple vers cet article qui parle des OGM et de leur impact sur l’environnement et sur la diversité génétique des semences, notamment les parties : « Les OGM font utiliser plus de pesticides », « Les OGM font diminuer la biodiversité », « Les OGM vont envahir la Terre » et « Les OGM tuent les abeilles »

https://www.afis.org/Idees-recues-et-rumeurs-autour-des-OGM

Je suis par ailleurs très surpris de voir sur un blog censé être de zététique (si je comprends bien le nom zet-ethique) un renvoi vers une conférence de Pierre-Henri Gouyon qui est un membre du Criigen (ayant réalisé la célèbre étude Séralini), ça me semble être une très mauvaise source d’informations quand on cherche à s’informer sur les OGM et à critiquer le discours de l’Afis à ce sujet.

« Si je fais ça un peu pour tous les sujets traités par ce média, je me rends compte qu’il y a un cadrage qui globalement défend les technologies, un cadrage pro-industrie. »

Je trouve que l’étiquette « pro vs anti industrie » n’est pas très claire : l’Afis ne publie pas nécessairement d’articles pro industrie fossiles, où pro industrie du bio. Il me semble que l’Afis « défend les technologies » quand les éléments scientifiques concernant ces technologies portés à notre connaissance méritent d’être connus du public. Je vous renvoie notamment vers la partie « Proindustrie » ? de cet article de blog

https://blogs.mediapart.fr/yann-kindo/blog/301020/les-gardiens-de-la-deraison

S’il existe des fois où l’Afis diffuse des « hoax » où des articles où vous avez eu besoin « vérifier qu’ils ne déforment pas les faits » n’hésitez pas à nous le signaler, sinon ce n’est pas obligé de sous-entendre que de tels articles existent 😉

Bonjour,

Étant monoparent de 3 gosses qui s’en occupe seule ce week end, je voulais attendre lundi pour éventuellement répondre, mais comme visiblement certains crient à la censure si on répond pas dans les 24h, je vais devoir les délaisser un peu pour le faire quand même là maintenant.

Patientez quand même quelques heures, si vous avez un peu de décence.

[petit edit: le « si vous avez un peu de décence » ne visait pas à répondre à l’auteur du commentaire mais à la déferlante de fans de l’Afis sur twitter. La formulation était maladroite, et l’auteur du com l’a pris pour lui. Je fais cet édit parce que Ce N’est Qu’une Théorie s’est excusé en com de la confusion, mais que son commentaire est peu visible – il arrive après notre pavé, loin de ce à quoi il répond. Il m’a semblé important de le rendre plus visible. Gaël Violet]

Bonjour

Je patiente sans problème.

Sachant que mon commentaire était pensé pour être le plus cordial possible, je ne suis pas certain qu’il était nécessaire de conclure votre commentaire par « si vous avez un peu de décence ».

Bonjour.

Voilà donc la réponse annoncée à votre commentaire, dont la première partie a été rédigée par Ce N’est Qu’une Théorie (puisqu’elle traite directement de son domaine de spécialité) et la seconde l’a été conjointement par CNQT et Gaël Violet.

La réponse est plus bas dans l’article, je considère qu’il faut aborder tous les enjeux qui peuvent faire changer d’avis sur le sujet. Je défends également cela dans https://cenestquunetheorie.wordpress.com/2020/01/05/methodes-3-communication-ethique/ , et nous le défendons également Gaël Violet et moi-même dans https://zet-ethique.fr/2020/03/24/les-gens-pensent-mal-le-mal-du-siecle-partie-6-6-synthese-contre-la-technocratie/, ne pas traiter tous les enjeux, ou ne pas au moins évoquer que des enjeux ne sont pas traités, cela participe au biais de cadrage, et un tel biais, notamment lorsqu’on a prétention à participer à la formation critique de son lectorat, induit ce même lectorat en erreur. Par ailleurs, l’article ne se réclame pas que d’une analyse sur la santé humaine, mais d’un approche One Health, qui est (critère minimum, il y a des critères essentiels à remplir en plus) l’intégration de toutes les problématiques de santé Humaine ET animales et environnementales à l’analyse du problème. La question de la diversité des semences relève de la santé environnementale, et la diversité tout court, de la santé animale. Dans un article qui se réclame du One Health, c’est donc *encore plus* essentiel de ne pas se laisser aller à un tel biais de cadrage.

– De une cela ne corrige aucunement le biais de cadrage de l’article spécifique : un document doit se suffire à lui même pour ne pas être trompeur, on ne peut raisonnablement pas faire un appel à une lecture exhaustive d’un site pour avoir le droit d’en critiquer le contenu, l’unité à lire pour critiquer, c’est ce que les lecteurs lambdas vont eux-même lire en général – des articles isolés- et sur quoi ils vont fonder leur avis temporaire;

– De deux, Il s’agit dans le lien que vous donnez de « debunk » des problématiques qui font le lien biodiversité-OGM, pas de les aborder en les prenant au sérieux. Et si je prends l’exemple qui est le plus proche de mon argument, sur la diversité :

Cet extrait, c’est… un gag?

Vous tombez mal, en fait, car même si j’ai posté la vidéo de PH Gouyon pour faire un renvoi plutôt que de trop m’étaler, cette critique, je l’ai émise sans lui et bien avant de voir qu’il en parlait aussi, c’est une critique évidente qui vient à l’esprit de tout chercheur en biologie de l’évolution. Et il se trouve que je suis biologiste de l’évolution.

Donc, l’argument des biologistes de l’évolution est que A L’ECHELLE MONDIALE, le monopole de production des semences sélectionnées par quelques labos, au lieu de l’être *de manière différente* par chacun des producteurs locaux, conduit probablement à une élimination générale de la diversité génétique dont on dispose en tant qu’humanité. Cela serait aggravé pour les OGMs car la production d’un OGM se fait par la transformation et reproduction d’une poignée de plans au maximum, là où la sélection habituelle procédait par sélection d’un nombre beaucoup plus important de plans (en fait, plus par élimination de certains plans). C’est une question technique, mais cette diversité découle de la taille efficace des populations de semences. Les enjeux de cela sont également des questions techniques mais essentielles. Il y a deux dimensions 1- le fait que le pool de diversité génétique est une ressource consomable qui se produit sur le très long temps, un peu comme le pétrole, et qu’il faut la préserver pour faire face aux changements environementaux du futur, et 2- la vulnérabilité immédiate de cultivars trop homogènes, par exemple, lors d’un imprévu écologique, les clones sont beaucoup moins résistants: ils vont tous mourir, là où dans un champ diversifié au niveau génétique, certains individus mourront mais « par chance », d’autres résisteront, la récolte sera juste « moins bonne » mais pas nulle. Pour celleux qui veulent creuser, lire par exemple : https://link.springer.com/article/10.1007/s13593-013-0138-9.

Revenons à l’extrait. Il est extrêmement manipulatoire, et j’ai l’impression d’avoir un argumentaire du niveau de ceux que j’avais à contrer quand je devais répondre aux créationnistes quand je le faisais encore. J’ai arrêté de guerre lasse, car comme l’enseigne la loi de Brandolini, il est toujours plus facile de répandre de fausses informations que de les contrer par une argumentation complète. Rien que cette phrase…. « La transgénèse est, par essence créatrice de biodiversité comme les autres méthodes de sélection génétique « . En termes de mécanismes, la transgénèse est « créatrice de diversité »…. un peu de la manière dont l’est la mutation génétique. Pour ceux qui ont quelques connaissances en évolution, l’évolution procède par mutation et sélection (+ dérive et migration, mais on peut comprendre les bases sans ces deux là). La sélection n’est PAS un processus de création de diversité, mais d’élimination de diversité. La mutation créé, la sélection… élimine. Cette phrase n’a donc aucun sens.

Deuxième phrase « On constate que la faune des champs de plantes Bt est nettement mieux préservée que dans ceux soumis à des traitements par des insecticides naturels ou obtenus par synthèse chimique. ». L’argument des biologistes de l’évolution parle de diversité génétique des espèces cultivées elles-même, et non de la diversité dans les champs. Un minimum de transparence imposerait déjà de spécifier que la question se pose de manière totalement différente aux différents « niveaux » de diversité. Par soucis d’espace et parce que je suis plus évolutionniste qu’écologue, je me limite à la question génétique pour l’instant, même si cette argument est de toutes manières aussi très mauvais (c’est un peu comme si je disais que les fruits par essence sont plus riches en nutriments que les légumes parce qu’ils ne sont pas cuits et que ça évite la destruction des nutriments, en vrai ça va dépendre de moulte facteurs, qui évidemment sont totalement invisibilisés dans l’argument. Pire, l’argument utilise le Bt, un OGM spécifique, pour répondre sur les OGM en général, c’est comme si on parlait de banane pour laisser entendre qu’on peut conclure sur les fruits en général).

Troisième et quatrième phrases : « Il est vrai que l’utilisation d’une variété commerciale d’un OGM comme le coton s’accompagne au début par une domination de la variété en question. Rapidement les agriculteurs obtiennent des variétés nouvelles résultant de croisements entre l’OGM et des variétés locales. Il n’est donc pas inévitable que les OGM renforcent la domination des grands semenciers. « . Les semenciers producteurs d’OGM se battent pour que cela soit sanctionné par la loi au nom de la violation de la propriété du brevet, et de nombreux producteurs refusent absolument que leurs semences soient « contaminées » par les production OGM. Cet argument ne peut être reçu sans une approche contextuelle et éthique, il le serait en fait seulement dans un monde non capitaliste où les bénéficiaires plutôt que les entreprises et les états ont la main sur les leviers de décision.

Cinquième phrase « C’est même le contraire qui s’annonce : les techniques mises en œuvre pour obtenir des OGM se banalisent et se répandent un peu partout. ». Il n’y a absolument AUCUN LIEN LOGIQUE entre cette phrase et la précédente. Les hybridations ne sont pas des techniques de production des OGMs. En revanche, cet argument pourrait à la limite être défendu si pour chaque population de cultivar hyper spécifique, on produisait un OGM puis on l’hybridait avec les plans de cette population de cultivar jusqu’à introgression totale. Cependant, pour que cela ne conduise pas à une perte du pool de la diversité dans ce cultivar, il faudrait que ce soit fait sur le temps long, et que les OGMs intégrés ne soient pas brevetés comme dit plus haut. Ça ne serait en réalité pas du tout rentable pour les semenciers, et ça ne pourrait donc être implémenté de cette manière que dans un monde…. communiste 🙂 Si les OGMs étaient utilisés ainsi, effectivement cet argument portant sur la diversité génétique serait caduque (la perte serait du même ordre de grandeur que dans tout processus de domestication d’espèce, à vue de nez). Mais contextuellement, faut pas rêver.

Dernière phrase « Par ailleurs, des variétés délaissées par manque de productivité, due par exemple à une sensibilité élevée vis-à-vis de maladies, peuvent être rapidement réhabilitées par des transferts de gènes. » Oui, c’est une des utilisations possibles des OGMs, mais c’est une maigre compensation face à toute la perte liée aux effets que nous avons décrits, et c’est une possibilité qui reste principalement théorique, il conviendrait de montrer que cela est effectivement fait et pas de manière exceptionnelle (ça le sera ou non selon les intérêts des semenciers, il sera souvent plus simple d’améliorer la variété qui présente déjà le plus d’avantages dans le contexte écologique). J’ai été voir la source à partir de laquelle ce paragraphe à été écrit, tout de même, et elle se présente comme une revue de littérature, mais la méthodologie par laquelle les articles cités ont été identifiés et échantillonnés n’est pas précisée… ce n’est pas une méta-analyse, et donc le cherry picking est totalement possible. Ainsi, quelques exemple sont utilisés mais ont une portée argumentative faible (= « à tel endroit, on voit qu’il n’y a pas de perte de diversité, donc il n’y en a pas forcément », en gros). Bref, elle ne permet pas de conclure, bien qu’elle avance pouvoir le faire (par ailleurs, l’auteur est un… consultant, il n’est pas rattaché à une institution de recherche, apparemment).

La question des OGMs ne peut être traitée sans une approche intégrative, prenant en compte des aspects éthiques, économiques, et politiques, ce que nous n’avons pas la prétention de faire dans un simple commentaire sous un article. Si certains étaient curieux, je ne crois pas que les OGMs représentent plus de dangers que de bénéfices en termes de santé humaine à court terme au moins, et les OGMs ne sont clairement pas mon combat. Au final, cet extrait est surtout quand même une occasion assez éloquente de montrer la taille de l’arnaque AFIS. Je viens de passer deux heures à écrire ce qui précède, vous admettrez qu’on ne pourra pas passer le même temps sur chacun des paragraphes de l’article.

Pour avoir discuté avec PH Gouyon à propos de Séralini, il considère que même si l’article de Séralini était de piètre qualité, il aurait fallu y répondre en accord avec les principes du disputatio, et non le censurer alors qu’il n’y avait aucune preuve de fraude scientifique. Je trouve que PH Gouyon se laisse effectivement parfois un peu embarquer par certains détracteurs des OGMs et technologies (par exemple il est également proche du groupe JP Vernant qui est un modèle de mépris élitiste vis à vis de la « populace » que les non diplômés seraient), mais pour avoir échangé avec lui quelques fois, il est sincère dans sa défense des libertés académiques et son combat porte vraiment sur l’assainissement des conditions de production du savoir. Sur le sujet spécifique où je l’ai cité, à savoir la question de la perte de la diversité génétique, je l’ai fait pour, comme je l’ai précisé, faire un renvoi plutôt qu’alourdir l’article, mais j’ai largement le bagage, en fait, pour jauger par moi-même de l’importance de cette question de la perte de diversité génétique.

Nous qualifions l’AFIS de pro-industrie non pas parce qu’elle défendrait toutes les industries sans distinction, mais parce qu’elles défends certaines industries en oblitérant toute une partie des débats dans nombre de ses articles, comme on vient de le montrer plus haut. Par ailleurs, nous renvoyer vers cet article n’est pas la meilleure idée du monde; cet article est un amas amorphe de mauvais arguments.

Prenons cet extrait :

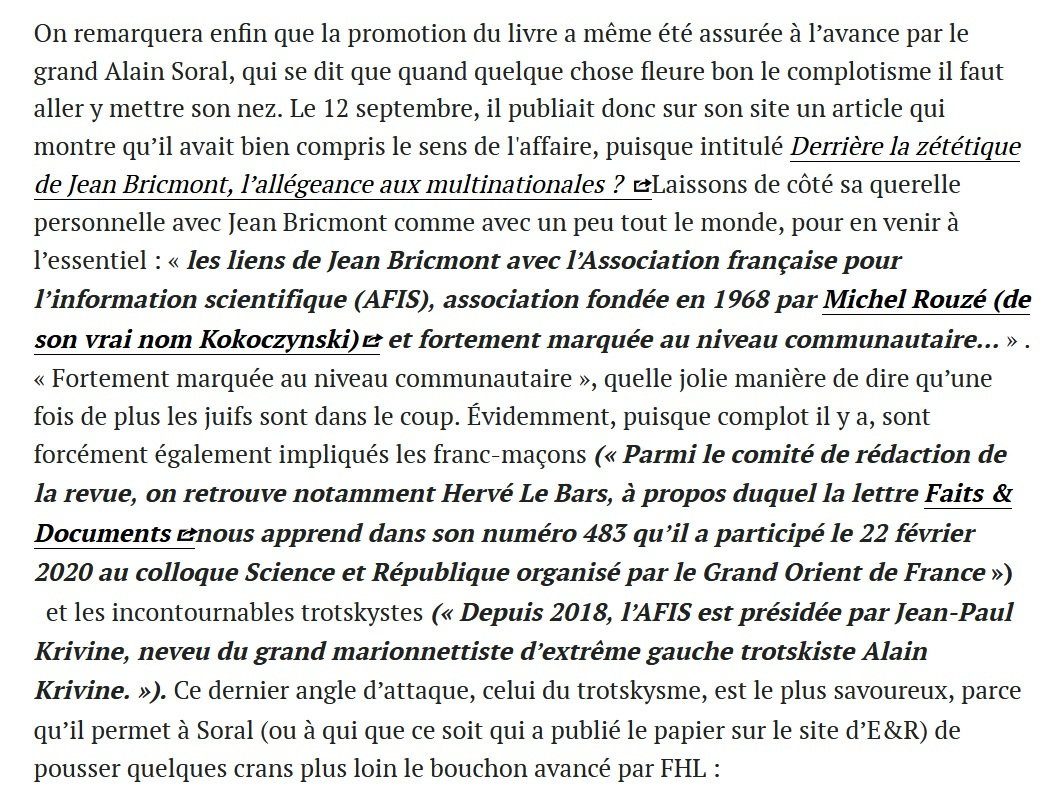

Même si ce n’est pas dans le sujet du présent article,, mettons quand même un petit coup de projecteur sur cette partie qui est l’acmé de l’article de Yann Kindo, quand on en vient à estimer la valeur de son argumentation. Quand Kindo en vient à voler au secours de Jean Bricmont, ce qu’il est en train de défendre en dit long sur sa probité.

Là on assiste à un bon vieux déshonneur par association (un vrai, une fois n’est pas coutume): vous vous rendez compte! Ce bouquin aurait été salué par des fascistes! Et l’usage du patronyme d’origine de Michel Rouzé, avec la petite allusion transparente au « niveau communautaire », est exactement l’expression qu’on peut attendre du site soralien (l’article d’ER est d’ailleurs antisémite tout du long). Seulement voilà: que nous apprend le fait de relever que Soral et sa bande aient voulu dire du bien de l’ouvrage? Comme personne ne peut empêcher d’être salué par qui veut, y compris par des gens qu’on désapprouve (nos critiques de l’Afis nous ont nous-mêmes valu des tentatives d’approches de Reopen911; et si on ne s’est pas privés de les envoyer paître, nous n’avons aucun moyen de contrôler l’usage qu’ils pourraient faire de nos articles… tout est récupérable, c’est facile : il suffit de déformer ce qui est dit), ce que Kindo est en train de faire est exactement ce qu’invoque à tout bout de champ, et que ce soit légitime ou non, la stratégie n°1 de l’Afis quand ils se défendent d’une critique: de l’insinuation.

Mais ce qui fait passer ce passage d’hypocrite à abject, c’est ce qu’il ne dit pas. Et ce qu’il ne dit pas, c’est qui est Jean Bricmont, et ce qu’il y a à dire de ses propres petites obsessions antisémites. Parce que souligner qu’un soutien dont on n’a aucun moyen de justifier qu’il ait pu être fait en accord avec les auteurs d’un livre, soit vérolé d’antisémitisme, ça aurait tout de suite moins d’impact si on s’arrêtait quelques instants sur qui on soutient soi-même. On cause quand même ici d’un homme qui ne répugne pas à l’usage de termes comme « cosmopolites » et qui voit dans les négationnistes (que lui préfère mettre entre guillemets) des « athées de la religion de la Shoah ». Bricmont serait plutôt du genre à défendre un soi-disant « antisionisme » tout en soulignant en privé des choses comme « Bien que l’antisémitisme et l’antisionisme soient conceptuellement distincts, je pense qu’ils sont néanmoins psychologiquement reliés. » (lettre citée par Pierre Stambul dans Israel-Palestine. Du refus d’être complice à l’engagement, et dont il est question dans cet article du site d’Yves Coleman, mondialisme.org. Notons que plus grand monde ne défendrait à ce jour que « l’antisionisme » de Bricmont serait « de gauche », comme il est dit à la fin de cet article).

Et c’est d’autant plus difficile à ignorer que la réponse de Bricmont au livre Les Gardiens de la Raison, réponse du reste fournie en lien dans le communiqué de l’Afis, est hébergée sur le site de l’ex-soralien, mais toujours confusionniste d’extrême-droite Vincent Lapierre: Le Média Pour Tous. D’un côté donc, Kindo relève que les soraliens ont pu dire du bien d’un livre sans apporter le moindre commencement d’indice que ses auteurs aient la moindre responsabilité dans ce soutien (et laisse très opportunément de côté « sa querelle personnelle avec Jean Bricmont », comme si elle n’avait rien à voir; quand justement elle illustre le fait qu’il s’agit ici simplement de régler ses comptes entre factions de l’extrême-droite). De l’autre, il ne se choque pas outre mesure que Bricmont héberge sa réponse sur un site d’extrême-droite, ni que l’Afis y renvoie sans même le moindre commentaire dans son communiqué officiel. Les doubles standards dans toute leur splendeur.

Mais revenons-en spécifiquement à cette partie censée être une réponse si lumineuse à l’accusation d’être « proindustrie ». Toute cette partie fait mine de répondre à cette accusation en opposant « l’industrie » à… « l’artisanat ». On accuserait l’Afis d’être pro-industrie, on serait donc en train de prôner un retour à l’artisanat, ben tiens mon lapin.

L’accusation n’a pourtant strictement rien à voir, en tout cas pour nous, et son sens est transparent – il faut à Kindo tout son art de la mauvaise foi pour faire « comme si ». L’accusation est de se placer systématiquement en défense des groupes industriels. Et on ne manque pas d’éléments pour appuyer ces accusations. Encore récemment, l’actuel président de l’association, JM Bréon, a pu profiter de la crise du Covid pour y aller d’un commentaire sarcastique sur l’industrie pharmaceutique, en mode « vous êtes bien contents de les trouver ». Or non, on n’est pas « contents »: le fait que les vaccins soient récupérés par des industriels qui ne les ont pas développés mais qui vont en tirer bénéfice n’a strictement rien de réjouissant; nous ne voyons pas qu’il faille se réjouir par exemple que le vaccin mis au point par l’université d’Oxford, et qu’ils avaient d’abord voulu diffuser en open source, ait été finalement vendu, sous la pression de la Gates Fundation, à une entreprise qui l’a géré comme une marchandise plutôt que comme un bien commun. C’est ce genre de défense du capitalisme industriel (ce qu’un esprit moins malhonnête qu’un Kindo entendrait quand on parle de « l’industrie » dans ce cadre) qui vaut à l’Afis cette critique.

Et puisque le running gag des défenses de l’Afis nous conduit à anticiper une réponse: non, nous ne supposons pas une « corruption »; c’est une défense idéologique. Nous avons d’ailleurs expliqué en détail la manière dont nous conceptualisons la manière dont des biais idéologiques s’introduisent dans les discours et pourquoi il est non seulement inutile mais carrément contre productif de supposer quelque corruption monétaire que ce soit sans preuve matérielle concrète, voir cet article sur le présent site. Nous nous bornons donc aux constats matériels : les biais systématiques qu’on peut identifier dans le travail de l’AFIS permettent d’identifier une inclinaison globale « pro-industries ».

On tend à considérer comme synonymes « progrès » et « progrès technique » à l’Afis. C’est comme ça qu’on se retrouve avec un trotskiste comme Kindo qui met de côté son supposé « anticapitalisme » par goût du productivisme.

Renvoyer à cet article est cependant un classique, c’est probablement l’article le plus cité lors du dernier raid de l’Afis et de ses fans sous l’article de Kum0kun (dans le présent site) qui faisait une recension du livre de Foucart, Horel et Laurens. Et par ailleurs, c’est assez logique qu’une association si prompte à se délivrer des autosatisfecits s’imagine que renvoyer à un tel article soit un argument recevable.

C’est fort civil de nous le suggérer, cependant nous sommes habitués aux non-réponses de l’Afis quand on les prend la main dans le pot à confiture de la désinformation. Il a quand même fallu un an après la publication de l’article de Meunier (https://archive.is/nBsUk) pour que l’Afis se décide à tenir compte des interrogations répétées de son lectorat face à un article qui inventait un faux scandale sur la base de « dude, trust me », et la réponse de l’Afis a été un pauvre entrefilet disant qu’ils regrettaient de ne pas avoir explicité qu’il s’agissait de l’avis de l’auteur (et ces regrets tardifs se sont limités à ça, ce qui, étant donnée la nature des accusations contenues dans ce passage, est une sinistre farce). Et encore là on est dans un cas rarissime où l’Afis a fait quelque chose, aussi pitoyable que soit ce « quelque chose ». On attend encore, 11 ans après, un correctif qui explique que quand Gauvrit annonce tout de go que finalement The Bell Curve ne fait que présenter un simple état de l’art sur le QI (au lieu de le présenter pour ce qu’il est: un pamphlet politique libertarien basé principalement sur un recyclage des délires racialistes de Richard Lynn et de ses copains du Pioneer Fund) est « son avis ». https://archive.is/rkT47

D’une manière générale, toute critique formulée à l’Afis a toujours rencontré, quand l’Afis a pris le temps de répondre, à la même attitude: des justifications, au lieu de correctifs. On a déjà parlé du cas Meunier, mais la chose est répétée inlassablement ad nauseam. A-t-on ouvert ses colonnes à un climato »sceptique » en plein dossier « climat » (https://archive.is/R5QmB) ? Mais c’était au nom du pluralisme enfin, vous voyez le mal partout (sur les rapports ambigus que l’Afis a pu entretenir avec le climato »scepticisme », comme nous savons lire, nous n’avons pas l’optimisme d’un Yann Kindo; nous avons lu sous la plume de son ancien président, Naud, comparer le livre climato »sceptique » de Claude Allègre aux Versets sataniques – rien que ça! Ou toujours de Naud en lien avec Krivine, une mise en doute du groupe 3 du Giec qui, contrairement au groupe 1, est composé de sociologues et d’économistes. Entre autres lamentables exemples). Les colonnes de l’AFIS regorgent par ailleurs d’autres articles douteux par leur manque de fermeté à l’égard du climato-scepticisme et leurs faveurs envers l’immobilisme face à la crise du climat (https://archive.is/r1i5g, https://archive.is/ypKW3, https://archive.is/dZJBa, https://archive.is/krIo9, entre autres). A-t-on publié un article confondant de bêtise et de désinformation sur l’écriture inclusive (https://archive.is/a0emI, voir l’article de BunkerD pour son debunking)? Mais enfin c’est un billet d’humeur, pas un article scientifique, où est le problème (au passage, je vous signale que même en étant ultra-charitable, Science et pseudosciences n’est pas une revue scientifique, pas plus d’ailleurs que ce blog. Cette différence entre « billet d’humeur » et « article scientifique ». dans le cadre de votre revue, est parfaitement inconséquente). S’est-on mis les anthropologues à dos en faisant une couverture au racisme implicite manifeste et suggérant une conception de l’histoire digne d’un épisode de la série de jeux Civilization? La couverture ne répond pas à la définition du « Racisme » dans le Larousse de Bréon, tout va bien (nous en avions parlé ici-même dans la notre article partie 3 de la série « des biais, de l’idéologie, et biais idéologiques »).

Même les zététiciens qui travaillent sur les thématiques traditionnelles de la zététique ont eu l’occasion d’expérimenter l’incapacité de l’Afis à prendre en compte la critique quand la revue s’est piquée d’y aller de son mot à dire sur leur champ habituel d’étude. On peut constater à ce lien dans le groupe zététique : https://www.facebook.com/groups/zetetique/permalink/10155902359478186/ . On notera le commentaire d’un pilier du scepticisme francophone :

Nous avions prévu de ne répondre à ce commentaire que lundi, mais l’agacement exprimé sur Twitter par Gaël Violet devant la répétition dans notre section commentaires de défenses peu informées de l’AFIS (agacement exprimé avec certes, des insultes), à été un prétexte trop opportun pour JM Bréon qui du coup nous à jeté sous les roues de ses 13 000 followers. Vous avez donc pu constatez que notre lassitude à l’égard de l’AFIS ne manque pas d’arguments.

On pourra s’amuser du fait que dans ses statuts, l’AFIS se dédouane par anticipation des propos tenus par ses membres dans ses pages comme en dehors, mais que lorsque ces membres sont attaqués pour ces discours, ils sont prompts à rebondir pour « diffamation ». Séparation de corps entre l’AFIS et ses membres… quand ça les arrange, donc.

https://www.afis.org/Qui-sommes-nous

Dans le futur, que l’AFIS soit informé : vos défenses, vous pouvez les faire par vos propres canaux. L’article de Kum0kun avait déjà en son temps, peu à peu, conduit à noyer la section commentaire sous des défenses semblables qui n’apportaient rien mais insistaient beaucoup quand même pour y aller de leur petit mot à dire. Nous avions même à l’époque eu les honneurs d’une non-réponse de Jean-Marie Bréon soi-même, sans du reste qu’elle soit plus honnête que celle de ses auxiliaires.

Il est déjà assez pénible de constater que la réputation dont jouissait votre association a perduré bien au-delà du seuil ou elle devrait être considérée comme usurpée, ce n’est pas pour que nous acceptions que notre section commentaire soit envahie de votre autopromotion complaisante. Nous n’avons pas la capacité de nuisance dont vous usez collectivement pour répondre à qui ose vous critiquer, quelle que soit la teneur de la critique et d’où qu’elle émane, mais peut être que cela ne vous arrange pas trop que nos critiques… soient aussi rendues accessibles à vos lecteurs (les nôtres ont les liens vers vos contenus, déjà…). A ce titre, considérez que le refus de vos commentaires sont notre aide bénévole pour lutter contre l’effet-Streisand.

NB. Pour ce qui est, plus spécifiquement, de l’auteur du commentaire auquel nous répondons ici, pour avoir brièvement échangé avec lui en MP, il nous est apparu très probable qu’il ait été de bonne foi; c’est un membre récent de l’association, selon ses propres dires, même si il les lit depuis plus longtemps. Et nous pensons que son message tient plus de la naïveté que de la mauvaise foi. Cependant, on ne peut pas en dire autant de membres plus chevronnés comme un Bréon; et d’autre part, dans la mesure où cette naïveté a conduit cette personne à nous répondre sur le mode habituel qui est celui des réponses de l’Afis, ce que ça change se limite en définitive aux regrets d’avoir été insultant dans le tweet de Gaël Violet évoqué plus haut. Pour le reste, son commentaire n’était ni plus pertinent que les défenses habituelles, ni moins énervant.

Bonjour

Tout d’abord merci à vous deux pour avoir pris le temps de rédiger une réponse aussi longue.

J’aurais du commencer par là mon commentaire initial, ça aurait peut être montré que je ne souhaitais pas être désagréable et apaisé les échanges : j’ai trouvé votre article très intéressant. Cependant, à la lecture j’avais été surpris de l’image de l’Afis qui pouvait en être perçue par un lecteur de passage, c’est pour ça que j’ai décidé de réagir uniquement à ce sujet. Rassurez-vous, le message « vos défenses, vous pouvez les faire par vos propres canaux » est bien reçu, je ne vais donc pas continuer à parler de l’Afis, sachez cependant que cette réponse a été lue et a permis de rouvrir certaines discussions qui n’auraient sûrement pas existé sans mon commentaire initial.

En particulier merci pour avoir alerté sur le biais de cadrage et les problématiques qui peuvent en découler, je rejoins votre avertissement, il faut essayer de faire attention à ce qu’on dit mais également à ce qu’on ne dit pas.

Je ne souhaitais pas porter de jugement de valeur à PH Gouyon, ni faire un déshonneur par association envers votre blog qui le citait, je voulais simplement partager le fait que quand je vois un membre du CRIIGEN parler d’OGM j’ai une alerte rouge.

Une dernière alerte que j’ai transmis à Gaël en mp mais que je pense utile de répéter : je n’ai vraiment pas l’impression que les insultes et dénigrements de vos contradicteurs soient la meilleure façon de faire passer votre message, de l’extérieur c’est difficile à comprendre d’où vient toute cette agressivité et je ne pense qu’il y a pas mal de monde qui sont dissuadés de lire vos articles sérieusement à cause de ces noms d’oiseaux qui volent régulièrement. Je comprends votre agacement cependant, surtout si ces échanges sont si répétitifs que ça.

Merci à vous d’avoir prêté attention à nos réponses.

J’aimerais revenir sur le dernier point évoqué, rapidement: dans mon fameux tweet j’ai commis la faute d’insulter bien trop large, et c’est une vraie faute puisque je sais qu’il se trouve encore au sein de l’Afis des personnes qui dans notre perspective ne relèvent pas de la crapulerie de ses instances dirigeantes mais de la simple naïveté – et je n’avais pour déterminer entre les deux, que le caractère stéréotypé de votre réponse, ce qui est une preuve mais assez faible et insuffisante. Sur ce point je ne puis que vous réitérer les regrets dont je vous ais déjà fait part en privé et sur twitter.

C’est aussi une remarque qui vaut pour beaucoup de contributeurs uniques ou occasionnels à la revue Science et pseudosciences. Il y a de bons articles dans la revue, il y a même des articles qui tiennent une position de contrepied vis-à-vis de la politique générale de la revue (si on cherche bien, on pourra même trouver des articles qui ne sont pas hostiles au principe de précaution). Mais c’est un problème, plutôt qu’un élément à décharge. La présence de bons articles dans la revue contribue à faire perdurer sa bonne réputation; et un journal ne peut pas être considéré comme de référence quand il mêle allégrement le vrai et le faux (ou pour le dire plus précisément: le bidonné) sans qu’il soit possible à un non-spécialiste de faire le tri, en particulier quand justement il s’adresse avant tout à des non-spécialistes. Même le fait d’être un contributeur unique plutôt qu’un pilier de la revue n’apporte aucune assurance, comme l’illustre sinistrement le cas de l’article de Meunier (qui, même si on ne l’a pas évoqué dans notre réponse, pose problème de bout en bout, pas uniquement sur la partie où il invente des morts dû au principe de précaution pendant la crise du choléra haïtienne. Si l’article laissé en pause et dont il est question dans la note 4 du présent article finit un jour par être publié, on aura l’occasion d’en parler: c’est justement autour de cet article qu’il est centré).

Mais je n’ai pas les mêmes regrets, en revanche, en ce qui concerne les têtes d’affiche de l’Afis comme JM Bréon – pour deux raisons. La première, c’est que l’Afis comme structure est à notre sens bien au-delà du réformable, et la nomination de Bréon est dans la continuité de sa politique depuis une quinzaine d’années, à cette innovation près, et c’est un signe supplémentaire de pourrissement, que sa profession, climatologue, a été instrumentalisée par l’Afis comme pauvre moyen de se prémunir rétroactivement contre les critiques pour avoir été coulant avec les climato »sceptiques » pendant des années. La seconde, est que face à la bonne réputation de l’Afis qui perdure encore chez les mal-informés, et tenant compte du fait que nous considérons qu’il n’y a plus rien à espérer de cette association, gueuler reste le seul moyen de se faire entendre – et pas par des Bréon, encore une fois nous n’espérons nul progrès de sa clique, et tenter de discuter avec lui ne mène à rien sinon à pouvoir estimer ses capacités, qui forcent le respect, à la danse de la gigue, pipeau en bouche. Les critiques en demi-teinte, d’expérience (ne pensez-pas que j’ai commencé par gueuler), sont trop facilement évacuées, quitte à les considérer formellement comme intéressantes et passer à autre chose sans en tenir compte (je précise en outre que la politique de l’Afis a plutôt été de s’attaquer à toute critique, y compris en demi-teinte, comme si on venait de tuer leur mère). D’autre part une critique en demi-teinte serait en-deçà de ce que devrait être une critique nécessaire. Nous ne parlons pas de points de détail, quand nous critiquons l’Afis.

Pardon, c’était pour la razzia de commentateurs jugeants sous le tweet de JM Bréon et qui allaient passer dans la journée.

Les hoax/dérapages de l’AFIS, puisque vous demandez qu’on vous les signale, sont assez connus.

Petit pot-pourri :

– Le désormais fameux « le DDT a été interdit sur des critères purement subjectifs » : https://twitter.com/ethalises/status/1313214791725600769

– Sur le réchauffement du climat, l’incroyable retard à l’allumage (20 ans) par rapport à la science :

https://twitter.com/ethalises/status/1277374316166950917

– Sur le climat encore, les choix de critique de livres incroyablement orientés de Michel Naud :

https://twitter.com/ethalises/status/1373668836180901888

– Sur la biodiversité :

https://twitter.com/factsory/status/1351251932900450305?s=20

– Sur la perméabilité de l’AFIS aux lobbies:

https://www.fil.univ-lille1.fr/~salson/zetetique/afis-lobbying.html

Bref, l’AFIS est pour moi une association à visée politique, comme en témoignent ses attaques du principe de précaution et ses soutiens obstinés à tout ce qui s’oppose à l’écologie politique. Au détriment de la science !

Bonjour et merci pour les liens.

(petite note rapide: nous n’avons pas eu le temps d’explorer les éléments fournis en profondeur, nous ne nous en portons par conséquent pas garants, toutefois, sans qu’on soit nécessairement d’accord avec tout, rien ne nous a choqué dans notre petite exploration un peu superficielle, et les éléments apportés nous ont semblé pertinents)

Bonjour,

Ma petite pierre sur Pierre-Henri Gouyon. Nos professeurs avaient jugés important de l’inviter dans le cadre de notre cursus de biotechnologie végétale, afin que nous ayons un peu de contradiction.

Qu’est ce que je dois faire d’un exposé de deux heures qui n’est rien d’autre qu’un point godwin (on a abordé l’eugénisme du 19e et 20é et les génocides nazis) ? Cela date un peu, mais il m’a juste conforté dans l’idée qu’il n’avait bien aucune idée de quoi il parlait ce jour la.

Au passage je n’ai pas souvenir qu’il disait tant de mal de Séralini et de son étude ce jour la, et il n’a pas fait ce qui m’aurait fait du bien à l’époque c’est a dire un exposé sur les liens insidieux qui peuvent exister entre le privé et le publique (j’ai découvert tous ça plus tard, et une personne comme Foucard me semble bien plus comprendre les enjeux et ces questions la).

Bonne journée

Bonjour.

Pour ce qui est de Foucart, vous avez en partie raison. En partie seulement, parce que, paradoxalement, vous avez raison: Foucart aurait été dans son domaine de spécialité pour parler des « liens insidieux qui peuvent exister entre le privé et le publique », quand Gouyon lui, est spécialiste de biologie de l’évolution. Comme je l’avais dit en réponse à des commentaires sous l’article de Kum0kun faisant un exposé de l’ouvrage Les Gardiens de la Raison, si on a de bonnes raisons de se méfier de Foucart, force est de constater qu’il a par le passé livré un travail compétent en matière de mise à jour des stratégies des groupes industriels, et est encore considéré comme une référence dans ces domaines (récemment encore, on trouve mention positive de son travail dans l’ouvrage Science et Territoires de l’Ignorance de Mathias Girel, dont je ne saurais trop conseiller la lecture, et dont il a été un peu question dans les médias récemment, et qui a me dit-on été une des bases pour un documentaire d’Arte presque éponyme, « La Fabrique de l’ignorance » – qu’en revanche je n’ai pas encore eu le temps de visionner), la difficulté avec lui étant de séparer ce qui tient du vrai travail d’investigation et ce qui tient de la mauvaise foi.

Mais revenons à Pierre-Henri Gouyon. Je dois vous dire que je suis assez sidéré de vous voir attribuer un point Godwin à une intervention dans laquelle ne pas parler du nazisme aurait été une faute. Il n’est absolument pas choquant qu’un cursus de biologie parle de la tâche sombre de la discipline qu’est l’eugénisme scientifique. Et il est impossible de parler de l’histoire de l’eugénisme sans parler du nazisme, et pas uniquement parce que l’eugénisme nazi fait partie de cette histoire, mais aussi parce qu’il n’a, sur le plan conceptuel, rien d’original – il s’est en particulier très largement appuyé sur les mouvements eugénistes américains – la différence se situant au-delà de la théorie eugéniste elle-même: le caractère industriel de la machine de mort nazie.

Bref, il n’a pas parlé de ce dont vous auriez voulu qu’il parle – soit. Mais ceci ne peut pas vraiment constituer un reproche. Et, je le répète: il est non seulement légitime, mais important que des biologistes aient une formation dans l’histoire de leur discipline, et en particulier, si on veut éviter de retomber dans les mêmes travers, de ses moments les plus sombres. L’eugénisme scientifique n’a pas disparu avec la chute du IIIème Reich, mais du moins ses applications étaient-elles mitigées par une nécessité relative de se faire discret. Cette nécessité de discrétion n’a du reste, et hélas, pas empêché la politique de stérilisation forcée des handicapés dans les pays scandinaves jusque dans les années 70, par exemple. Quant au pays qui avait jusqu’en 1942 été le champion de l’eugénisme, les États-Unis d’Amérique, il est peut-être opportun de rappeler qu’il se fait encore prendre la main dans le pot à confiture de la stérilisation forcée des pauvres et des minorités raciales, comme le rapporte cet article de l’ACLU. Pensez à consulter les hyperliens, notamment celui menant vers la décision de la Cour Fédérale concernant l’affaire Relf v. Weinberger et tout particulièrement l’article « The Story of Madrigal v. Quilligan: Coerced Sterilization of Mexican-American Women« .

Maintenant que le souvenir de l’eugénisme en actes s’efface peu à peu des mémoires, il commence à nouveau à sortir la tête. Il trouve notamment un défenseur en la personne de Singer via son Journal of Controversial Ideas; et Mr Phi a fait quelques vidéos pour défendre l’idée d’un eugénisme ‘cool’, et réévaluer l’eugénisme sur la base de ses arguments revient à peu près à ce qu’on propose de réévaluer la pertinence du nazisme au nom de l’aménagement de crapauducs sous les autoroutes allemandes (et là vous voyez, c’est un authentique point Godwin, et qui illustre à merveille le problème dudit point, puisqu’il ne prend pas en considération la pertinence du parallèle). Sans même parler de l’implantation d’un eugénisme racialiste dans la stricte continuité du nazisme au sein du monde académique, via les revues liées au Pioneer Fund comme Mankind Quarterly, et jusqu’au sein de revues du groupe Elsevier, et sa reprise politique par des libertariens comme Charles Murray pour justifier de prendre des mesures visant explicitement à limiter la natalité des plus pauvres, supposés être génétiquement déficients, comme on peut le voir dans The Bell Curve, au reste à son tour défendu par Nicolas Gauvrit à grands coups d’aveuglement volontaire et de contrevérités dans les colonnes de Science et pseudosciences. Il lui a sans doute fallu mettre toute sa mauvaise foi en action pour prétendre qu’un ouvrage qui contient ce genre de passages n’a pas une vocation eugéniste, ni un objectif politique, mais serait une simple « reprise [de] près d’un siècle de recherches sur le QI »:

Ce n’est pas une bonne nouvelle, et le premier moyen de combattre cette dynamique de retour en grâce est de mettre en garde la profession concernée. Et à cet égard, Pierre-Henri Gouyon était effectivement une des personnes toutes indiquées pour aborder ces aspect historiques au sein de son intervention dans votre cursus. On pourra s’en assurer en consultant l’ouvrage Les avatars du gène, Pierre-Henry Gouyon, Jean-Pierre Henry et Jacques Arnould. sous-chapitre II.4 « Eugénisme et Lyssenkisme ». p.89-100. Même si le chapitre est circonstancié et assez chronologique, et à ce titre en-deçà de ce que peut être l’histoire, science critique s’il en est, quand elle est à son meilleur, il est visible pour l’amateur d’histoire que je suis qu’il sait de quoi il parle – et je ne reprocherais donc pas à Pierre-Henri Gouyon de ne pas être un historien de pointe. Pour une intervention ça n’était pas nécessaire de l’être. Il est vrai par ailleurs, mais c’est sur une autre question, que d’aucuns ont pu, peut-être légitimement, lui reprocher de sortir un peu trop de son domaine de compétence pour aborder, dans le cadre de son travail d’enseignant (à titre personnel il en aurait parfaitement le droit), des questions qui ne relèvent pas de sa spécialité (il donne un cours complet sur l’éthique et s’est fait critiquer à son sujet; nous ne pouvons vraiment juger de la pertinence de ces critiques toutefois – mais il est important de prendre en compte le fait qu’elles existent).

En espérant que cette réponse vous soit utile.

Bonjour,

Merci pour la réponse.

J’avais le livre de Mr Girel en tête mais j’avais oublié le nom de l’auteur et du livre, donc j’ai cité Foucart. Ce qui nous permet au moins une discussion sur ce personnage.

Pour faire cours, si c’est dommageable de venir avec cet angle parmi des étudiants en génétique végétale, qui ont déjà ce recule sur l’eugénisme, en leur expliquant que le problème des OGM c’est le nazisme du 20 siècle… On aurait aimé des arguments scientifiques, ou même des analyses comme celle proposées par Girel.

Notre prof l’a invité et s’est amusé de nous voir trouver ce monsieur à côté de la plaque très franchement…

Bonjour,

Existe-t-il un debunk ou un début de debunk de la série de vidéo de Psyhodelik qui tente de ridiculiser les gauchistes et qui inclus youtube.com/watch?v=s_xp6yEzYVE et youtube.com/watch?v=ugvcoVhpRy4 . J’ai cherché pendant 30 minute et j’ai rien trouvé.

C’est pour aider un ami.

Bonjour.

Je ne connais pas de critique systématique du détail du travail (ou de ce qui en tient lieu) de Psyhodélik, je demanderai autour de moi cependant. En attendant, Jack0tte (dans cette vidéo) et le Bouseux (dans celle-ci, en collab’ avec Jack0tte) ont parlé du personnage et de sa méthode en général, ce qui pourra vous donner des éléments.